在Hadoop的安装过程中,用户常因系统兼容性、环境配置、权限管理等问题导致安装失败或服务无法启动。本文基于实际安装经验,安装流程中的高频问题及其解决方案,涵盖从系统准备到环境验证的各环节,并提供工具推荐以辅助高效部署。以下是关键问题分析与应对策略:

一、安装前的系统配置问题

1. 防火墙与主机名配置不当

现象:启动Hadoop时出现网络连接错误(如`NoRouteToHostException`)。

原因:防火墙未关闭或主机名未正确配置,导致节点间通信受阻。

解决方案:

关闭防火墙:

Linux系统:执行 `sudo ufw disable` 永久关闭防火墙,或使用 `systemctl stop firewalld` 临时关闭。

Windows系统:需通过控制面板或安全软件禁用防火墙。

配置主机名:

修改 `/etc/hostname` 文件并重启生效,同时更新 `/etc/hosts` 确保所有节点IP与主机名映射正确。

2. 依赖软件缺失或版本冲突

现象:安装过程中提示JDK未安装或版本不兼容。

原因:未安装Java或版本不符合Hadoop要求。

解决方案:

安装JDK:推荐使用JDK 8或11,通过命令 `sudo apt install openjdk-11-jdk`(Linux)或官网下载安装包(Windows)完成安装。

验证环境变量:在终端输入 `java -version` 确认版本,若未识别则需手动设置 `JAVA_HOME`。

二、关键安装步骤的常见错误

1. 环境变量配置错误

现象:启动Hadoop时提示 `JAVA_HOME not found` 或 `HADOOP_HOME未设置`。

原因:未正确配置环境变量或路径引用错误。

解决方案:

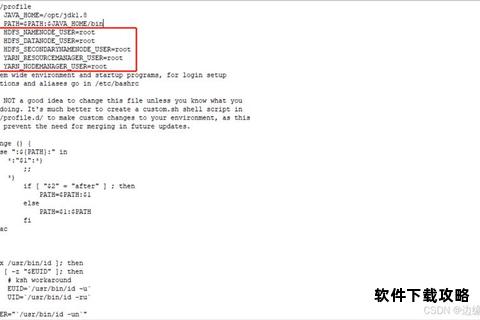

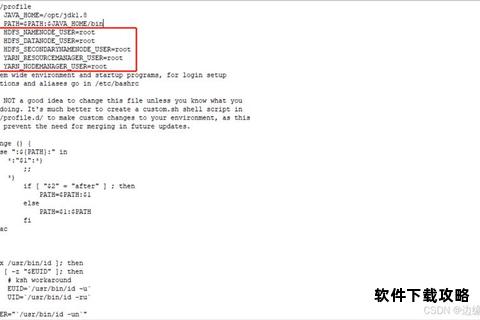

编辑配置文件:

在 `hadoop-env.sh` 中指定绝对路径:`export JAVA_HOME=/usr/lib/jvm/java-11-openjdk`(路径需与实际安装目录一致)。

在 `~/.bashrc` 或 `/etc/profile` 中添加 `export HADOOP_HOME=/opt/hadoop` 并执行 `source` 命令使其生效。

验证配置:使用 `echo $HADOOP_HOME` 和 `hadoop version` 确认变量生效。

2. 权限与用户管理问题

现象:操作文件时提示权限不足(如 `Permission denied`)。

原因:未正确设置文件权限或未使用专用用户运行Hadoop。

解决方案:

创建专用用户:

在Linux中执行 `sudo useradd hadoop` 创建用户,并通过 `chown` 命令将安装目录权限赋予该用户。

配置SSH免密登录:

生成密钥对:`ssh-keygen -t rsa`,将公钥复制到目标节点:`ssh-copy-id hadoop@node1`,测试免密登录是否成功。

三、启动与运行阶段的故障排查

1. NameNode或DataNode启动失败

现象:执行 `start-dfs.sh` 后进程未启动,日志显示端口冲突或文件系统未格式化。

原因:多次格式化导致元数据不一致,或端口被占用。

解决方案:

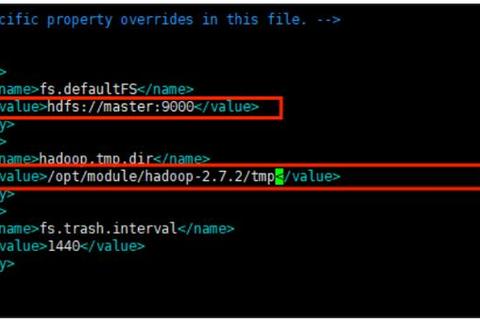

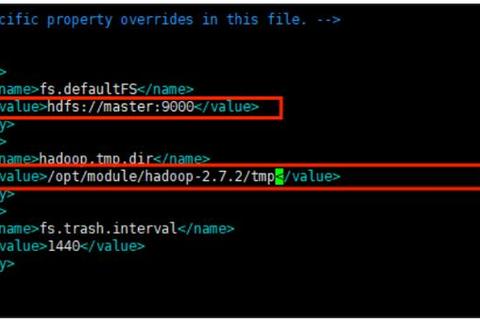

格式化HDFS:仅首次启动时执行 `hdfs namenode -format`,若重复格式化需删除 `dfs.data.dir` 和 `dfs.name.dir` 目录后重新操作。

释放占用端口:使用 `lsof -i:50070` 查找占用端口的进程并终止。

2. 本地库加载警告

现象:运行Hadoop时提示 `Unable to load native-hadoop library`。

原因:安装的Hadoop版本与系统架构(32位/64位)不匹配。

解决方案:

下载对应版本的64位编译本地库,替换 `lib/native` 目录中的文件。

四、辅助工具推荐

1. 文件传输工具

WinSCP(Windows/Linux):图形化界面支持SCP协议,便于上传安装包至虚拟机。

XFTP:支持断点续传,适合大文件传输。

2. SSH客户端

PuTTY(Windows):轻量级工具,支持远程连接Linux节点。

Cygwin(Windows):模拟Linux环境,支持SSH服务配置。

3. 日志分析工具

tail -f(Linux):实时查看日志文件变化,快速定位错误。

五、

Hadoop的安装问题多集中于环境配置与权限管理,通过逐步验证系统设置、依赖项完整性及服务端口状态,可显著降低失败概率。对于复杂问题,建议优先查阅日志文件(如 `logs/hadoop-.log`)获取详细报错信息,并结合本文提供的解决方案针对性处理。掌握工具链的使用(如SSH、SCP)能够进一步提升部署效率,为后续的大数据开发奠定稳定基础。